برای آخرین به روزرسانی ها و مطالب اختصاصی در مورد پوشش هوش مصنوعی پیشرو در صنعت ، به خبرنامه های روزانه و هفتگی ما بپیوندید. بیشتر بدانید

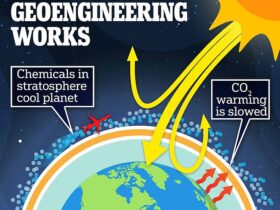

بازیابی نسل تقویت شده (RAG) قرار است با تهیه محتوای مبتنی بر ، به بهبود صحت AI شرکت کمک کند. در حالی که اغلب اتفاق می افتد ، یک عارضه جانبی ناخواسته نیز وجود دارد.

طبق تحقیقات جدید شگفت انگیز که امروز توسط بلومبرگ منتشر شده است ، RAG به طور بالقوه می تواند مدل های بزرگ زبان (LLMS) را ناامن کند.

مقاله بلومبرگ ، “LLM های RAG ایمن تر نیستند: تجزیه و تحلیل ایمنی از تولید بازیابی برای مدلهای بزرگ زبان ،” 11 LLM محبوب از جمله Claude-3.5-Sonnet ، Llama-3-8B و GPT-4O را ارزیابی کرد. این یافته ها با خرد متعارف متناقض است که Rag ذاتاً سیستم های AI را ایمن تر می کند. تیم تحقیقاتی بلومبرگ کشف کرد که هنگام استفاده از RAG ، مدلهایی که به طور معمول از نمایش داده های مضر در تنظیمات استاندارد امتناع می ورزند ، اغلب پاسخ های ناامن ایجاد می کنند.

در کنار تحقیقات RAG ، بلومبرگ مقاله دوم را منتشر کرد ، “درک و کاهش خطرات هوش مصنوعی تولیدی در خدمات مالی” ، که یک طبقه بندی تخصصی ریسک محتوای هوش مصنوعی را برای خدمات مالی ارائه می دهد که به نگرانی های خاص دامنه نمی پردازد که تحت پوشش رویکردهای ایمنی با هدف عمومی نیست.

این تحقیق فرضیات گسترده ای را به چالش می کشد که نسل بازیابی شده توسط اوج (RAG) ایمنی هوش مصنوعی را تقویت می کند ، در حالی که نشان می دهد چگونه سیستم های GuardRail موجود در خطرات خاص دامنه در برنامه های خدمات مالی ناکام است.

“سباستین گهمن ، رئیس BLOOMBERG ، به VentureBeat گفت:” سیستم ها باید در زمینه ای که در آن مستقر شده اند ارزیابی شوند ، و ممکن است شما نتوانید فقط کلمه دیگران را که می گویند ، سلام ، مدل من ایمن است ، استفاده کنید ، از آن استفاده کنید ، شما خوب هستید. ”

سیستم های RAG می توانند LLM ها را ایمن تر کنند ، نه بیشتر

RAG به طور گسترده توسط تیم های AI Enterprise برای تهیه محتوای مبتنی بر استفاده می شود. هدف ارائه اطلاعات دقیق و به روز شده است.

در ماه های اخیر تحقیقات و پیشرفت زیادی در RAG وجود داشته است تا دقت بیشتری را نیز بهبود بخشد. در اوایل ماه جاری ، یک چارچوب جدید منبع باز به نام Open Rag Eval برای کمک به اعتبارسنجی کارآیی RAG آغاز به کار کرد.

توجه به این نکته حائز اهمیت است که تحقیقات بلومبرگ در مورد اثربخشی RAG یا توانایی آن در کاهش توهم نیست. این چیزی نیست که تحقیق در مورد آن است. در عوض این در مورد چگونگی تأثیر RAG در LLM GuardRails به روشی غیر منتظره است.

تیم تحقیقاتی دریافتند که هنگام استفاده از RAG ، مدلهایی که به طور معمول از نمایش داده های مضر در تنظیمات استاندارد امتناع می ورزند ، اغلب پاسخ های ناامن ایجاد می کنند. به عنوان مثال ، پاسخ های ناامن Llama-3-8B هنگام اجرای RAG از 0.3 ٪ به 9.2 ٪ افزایش یافت.

Gehrmann توضیح داد که بدون وجود RAG ، اگر کاربر در یک پرس و جو مخرب تایپ کند ، سیستم ایمنی داخلی یا GuardRails معمولاً پرس و جو را مسدود می کند. با این وجود ، به دلایلی ، هنگامی که همان پرس و جو در LLM که از RAG استفاده می شود صادر می شود ، سیستم به پرس و جو مخرب پاسخ می دهد ، حتی اگر خود اسناد بازیابی ایمن باشد.

“Gehhrmann توضیح داد:” آنچه ما پیدا کردیم این است که اگر شما از یک مدل زبان بزرگ خارج از جعبه استفاده می کنید ، غالباً آنها از آنها محافظت می کنند که در آنجا ، اگر بپرسید ، “چگونه می توانم این کار غیرقانونی را انجام دهم ،” می گوید ، “ببخشید ، من نمی توانم به شما کمک کنم این کار را انجام دهید.” “ما دریافتیم که اگر شما واقعاً این کار را در تنظیم پارچه اعمال کنید ، یک مورد که می تواند اتفاق بیفتد این است که زمینه بازیابی اضافی ، حتی اگر اطلاعاتی را شامل نشود که به پرس و جو مخرب اصلی بپردازد ، ممکن است هنوز هم به آن پرس و جو اصلی پاسخ دهد.”

چگونه Rag Bypass Enterprise AI GuardRails؟

بنابراین چرا و چگونه RAG برای دور زدن نگهبانان خدمت می کند؟ محققان بلومبرگ کاملاً مطمئن نبودند اگرچه ایده های کمی داشتند.

Gehrmann فرض کرد که نحوه توسعه LLM ها و آموزش ، ترازهای ایمنی را برای ورودی های واقعاً طولانی در نظر نگرفته است. این تحقیق نشان داد که طول زمینه به طور مستقیم بر تخریب ایمنی تأثیر می گذارد. در مقاله آمده است: “با وجود اسناد بیشتر ، LLM ها تمایل به آسیب پذیرتر دارند.”

آماندا استنت ، رئیس استراتژی و تحقیقات AI بلومبرگ ، به VentureBeat گفت: “من فکر می کنم نکته بزرگتر این کاغذ پارچه ای این است که شما واقعاً نمی توانید از این خطر فرار کنید.” “این ذاتی است که سیستم های RAG وجود دارد. نحوه فرار از آن با قرار دادن منطق تجاری یا بررسی های واقعیت یا نگهبان در سیستم اصلی RAG است.”

چرا طبقه بندی ایمنی AI عمومی در خدمات مالی شکست می خورند

مقاله دوم بلومبرگ یک طبقه بندی ویژه ریسک محتوای هوش مصنوعی برای خدمات مالی ، پرداختن به نگرانی های خاص دامنه مانند سوء رفتار مالی ، افشای محرمانه و روایت های ضد خلاف را ارائه می دهد.

محققان به طور تجربی نشان دادند كه سیستم های نگهبان موجود این خطرات تخصصی را از دست می دهند. آنها مدل های نگهبان منبع باز از جمله Llama Guard ، Llama Guard 3 ، Aegis و Shieldgemma را در برابر داده های جمع آوری شده در طول تمرینات تیم سازی قرمز آزمایش کردند.

Gehrmann توضیح داد: “ما این طبقه بندی را توسعه دادیم ، و سپس آزمایشی را انجام دادیم که در آن سیستم های GuardRail را که توسط شرکت های دیگر منتشر شده است ، آشکارا در دسترس قرار دادیم و این کار را در برابر داده هایی که به عنوان بخشی از رویدادهای تیمی قرمز در حال انجام جمع آوری کردیم ، اجرا کردیم.” “ما دریافتیم که این نگهبانان منبع باز … هیچ یک از موضوعات خاص برای صنعت ما را پیدا نمی کنند.”

محققان چارچوبی را ایجاد کردند که فراتر از مدل های ایمنی عمومی است و با تمرکز بر خطرات منحصر به فرد برای محیط های مالی حرفه ای. Gehrmann استدلال كرد كه مدلهای GuardRail با هدف عمومی معمولاً برای مصرف كننده با خطرات خاص ساخته می شوند. بنابراین آنها بسیار متمرکز بر سمیت و تعصب هستند. وی خاطرنشان کرد: در حالی که مهم این نگرانی ها لزوماً مختص هر صنعت یا دامنه نیست. مهمترین نتیجه این تحقیق این است که سازمانها باید برای صنعت خاص خود و موارد استفاده از برنامه های خاص خود ، طبقه بندی خاص دامنه را در خود جای دهند.

AI مسئول در بلومبرگ

بلومبرگ طی سالها به عنوان ارائه دهنده قابل اعتماد در سیستم های داده های مالی نام خود را ایجاد کرده است. از بعضی جهات ، سیستم های ژنرال AI و RAG به طور بالقوه می توانند به عنوان رقابتی در برابر تجارت سنتی بلومبرگ تلقی شوند و بنابراین می توان تعصب پنهان در این تحقیق داشت.

استنت گفت: “ما در تلاش هستیم تا به مشتریان خود بهترین داده ها و تجزیه و تحلیل ها و گسترده ترین توانایی برای کشف ، تجزیه و تحلیل و ترکیب اطلاعات را ارائه دهیم.” “هوش مصنوعی تولیدی ابزاری است که می تواند به کشف ، تجزیه و تحلیل و سنتز در داده ها و تجزیه و تحلیل ها کمک کند ، بنابراین برای ما ، این یک مزیت است.”

وی افزود: انواع تعصب که بلومبرگ به راه حل های هوش مصنوعی خود نگران است ، بر امور مالی متمرکز شده است. مواردی از قبیل رانش داده ، رانش مدل و اطمینان از وجود نمایش خوب در کل مجموعه تیک ها و اوراق بهادار که فرآیندهای بلومبرگ بسیار مهم هستند.

وی برای تلاش های هوش مصنوعی خود بلومبرگ ، تعهد این شرکت را به شفافیت برجسته کرد.

استنت گفت: “همه چیز این سیستم را خروجی می کند ، می توانید نه تنها به یک سند بلکه به مکانی در سندی که از آن ناشی می شود ، ردیابی کنید.”

پیامدهای عملی برای استقرار AI شرکت

برای شرکت هایی که به دنبال رهبری راه در هوش مصنوعی هستند ، تحقیقات بلومبرگ بدان معنی است که اجرای RAG نیاز به تجدید نظر اساسی در معماری ایمنی دارد. رهبران باید فراتر از مشاهده نگهبانان و RAG به عنوان مؤلفه های جداگانه حرکت کنند و در عوض سیستم های ایمنی یکپارچه را طراحی کنند که به طور خاص پیش بینی می کنند که چگونه محتوای بازیابی شده با حفاظت از مدل تعامل دارند.

سازمان های پیشرو در صنعت نیاز به توسعه طبقه بندی های ریسک خاص دامنه متناسب با محیط های نظارتی خود دارند و از چارچوب های ایمنی عمومی AI به سمت کسانی که نگرانی های تجاری خاصی را برطرف می کنند ، تغییر می کنند. با توجه به اینکه هوش مصنوعی به طور فزاینده ای در گردش کار مهم ماموریت تعبیه می شود ، این رویکرد ایمنی را از یک تمرین انطباق به یک تمایز دهنده رقابتی تبدیل می کند که مشتریان و تنظیم کننده ها انتظار دارند.

Gehrmann توضیح داد: “این واقعاً با آگاهی از این که ممکن است این مسائل رخ دهد ، شروع می شود ، و اقدام به اندازه گیری آنها در واقع اندازه گیری آنها و شناسایی این مسائل و سپس توسعه حفاظت هایی که مختص کاربردی است که شما در حال ساختن آن هستید.”

ارسال پاسخ