پس از برنامه های قبلی اعلام شده ، Nvidia گفت که عناصر جدید جدیدی از اجرا را باز کرده است: پلت فرم AI ، از جمله برنامه زمانبندی KAI.

برنامه ریزی یک راه حل برنامه ریزی GPU Kubernetes بومی است که هم اکنون تحت مجوز Apache 2.0 موجود است. در ابتدا در Run: AI Platform ، Kai Scheduler اکنون در دسترس جامعه است و در عین حال به عنوان بخشی از NVIDIA RUN: AI Platform نیز بسته بندی و تحویل داده می شود.

Nvidia گفت این ابتکار تأکید بر تعهد Nvidia برای پیشبرد زیرساخت های منبع باز و شرکت AI ، تقویت یک جامعه فعال و مشارکتی ، تشویق کننده کمک ها ،

بازخورد و نوآوری.

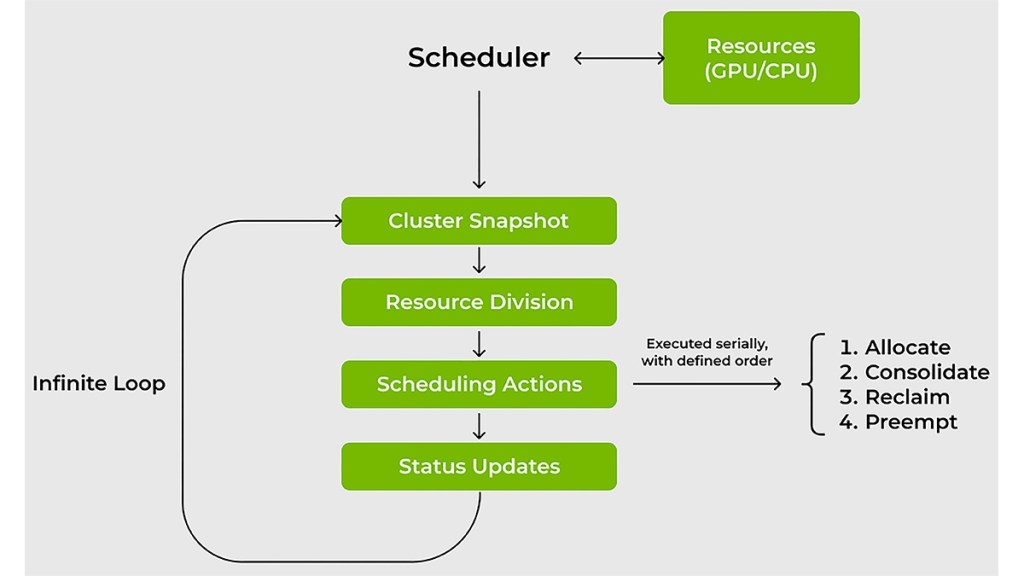

در پست خود ، رونن دار و اكین كربولوت NVIDIA مروری بر جزئیات فنی كی برنامهر ارائه داد ، ارزش آن را برای تیم های IT و ML برجسته می کند و چرخه برنامه ریزی و اقدامات را توضیح می دهد.

مزایای برنامه ریز کای

مدیریت بارهای کار هوش مصنوعی در GPU و CPU تعدادی از چالش ها را نشان می دهد که برنامه ریزان منابع سنتی اغلب در برآورده شدن ناکام هستند. برنامه ریزی برای پرداختن به طور خاص به این موضوعات تهیه شده است: مدیریت نوسان خواسته های GPU. کاهش زمان انتظار برای دسترسی به محاسبه ؛ ضمانت منابع یا تخصیص GPU ؛ و اتصال یکپارچه ابزارها و چارچوب های AI.

مدیریت نوسان GPU

بار کاری AI می تواند به سرعت تغییر کند. به عنوان مثال ، شما ممکن است فقط به یک GPU برای کار تعاملی نیاز داشته باشید (به عنوان مثال ، برای اکتشاف داده ها) و سپس ناگهان به چندین GPU برای آموزش توزیع شده یا آزمایش های متعدد نیاز دارید. برنامه ریزان سنتی با چنین تنوع می جنگند.

KAI Scheduler به طور مداوم مقادیر تقسیم عادلانه را محاسبه می کند و سهمیه ها و محدودیت ها را در زمان واقعی تنظیم می کند ، به طور خودکار با تقاضای بار کار فعلی مطابقت دارد. این رویکرد پویا به اطمینان از تخصیص کارآمد GPU بدون مداخله دستی مداوم از سوی مدیران کمک می کند.

کاهش زمان انتظار برای دسترسی محاسبه

برای مهندسان ML ، زمان از ذات است. برنامه ریزی با ترکیب برنامه ریزی باند ، اشتراک GPU و یک سیستم صف سلسله مراتبی که به شما امکان می دهد دسته های مشاغل را ارسال کنید و سپس قدم بردارید ، اطمینان حاصل کنید که وظایف به محض در دسترس بودن منابع و تراز اولویت ها و عدالت ، کار را انجام می دهد.

برای بهینه سازی بیشتر مصرف منابع ، حتی در مواجهه با نوسان تقاضا ، برنامه ریزی کننده

از دو استراتژی مؤثر برای هر دو کار GPU و CPU استفاده می کند:

بن بسته بندی و ادغام: استفاده از محاسبات را با مبارزه با منابع حداکثر می کند

تکه تکه شدن – بسته بندی کارهای کوچکتر در GPU ها و CPU های جزئی استفاده شده و پرداختن

تکه تکه شدن گره با استفاده مجدد از وظایف در میان گره ها.

پخش: به طور مساوی بار کار را در گره ها یا GPU ها و CPU ها توزیع می کند تا به حداقل برسد

بار هر گره و در دسترس بودن منابع در هر بار کار حداکثر می شود.

ضمانت منابع یا تخصیص GPU

در خوشه های مشترک ، برخی از محققان برای اطمینان از در دسترس بودن در کل ، از GPU های بیشتری نسبت به زمان لازم استفاده می کنند. این عمل می تواند به منابع کم بهره منجر شود ، حتی اگر تیم های دیگر هنوز سهمیه های بلااستفاده داشته باشند.

KAI Scheduler با اجرای ضمانت های منابع ، این موضوع را به این موضوع می پردازد. این تضمین می کند که تیم های تمرین کننده هوش مصنوعی GPU های اختصاصی خود را دریافت می کنند ، در عین حال به صورت پویا منابع بیکار را به سایر بارهای کاری تبدیل می کنند. این رویکرد مانع از دست زدن به منابع می شود و باعث افزایش کارآیی کلی خوشه می شود.

اتصال بارهای AI با چارچوب های مختلف هوش مصنوعی می تواند دلهره آور باشد. به طور سنتی ، تیم ها با پیچ و خم پیکربندی های دستی روبرو می شوند تا بارهای کاری را با ابزارهایی مانند Kubeflow ، Ray ، Argo و اپراتور آموزش پیوند دهند. این پیچیدگی نمونه سازی را به تأخیر می اندازد.

Kai Scheduler با ارائه یک podgrouper داخلی که به طور خودکار با این ابزارها و چارچوب ها-کاهش پیچیدگی پیکربندی و سرعت بخشیدن به توسعه ، به این موضوع می پردازد ، این موضوع را می پردازد.

ارسال پاسخ