به گزارش بخش موبایل رسانه اخبار تکنولوژی تک فاکس،

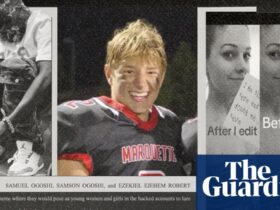

هوش مصنوعی توسط کلاهبرداران برای دستکاری شما از طریق “مهندسی اجتماعی” استفاده می شود

ایوان درنبوش ، کارشناس سابق امنیت سایبری NSA ، به Forbes گفت که هوش مصنوعی می تواند به کلاهبرداران کمک کند تا سریعتر از همیشه پیام های باورنکردنی ایجاد کنند. با هوش مصنوعی ، هزینه ایجاد این حملات بسیار پایین است. درنبوش گفت: “هوش مصنوعی در حال کاهش هزینه های مجرمان است ، و جامعه به روش های جدیدی برای کاهش پرداخت های خود ، افزایش بودجه عملیاتی آنها یا هر دو نیاز دارد.”

در حالی که بیشتر شما وقتی در مورد “Deepfakes” می شنوید به فیلم های جعلی فکر می کنید ، آخرین نبرد حول صوتی جعلی و استفاده از آن برای کلاهبرداری افراد می چرخد. تصور کنید که از دخترتان تماس تلفنی دریافت می کنید که او بر خلاف خواست خود نگه داشته می شود و فقط در صورت پرداخت باج ، آزاد می شود. در حالی که کلاهبرداری از این دست قبلاً بدون هوش مصنوعی موفق شده است ، تصور کنید صدای لرزان و ترسناک دختر ، همسر یا پسر خود را شنیدید ، یا حتی یکی از والدین شما در مورد مصیبت وحشتناک خود به شما می گوید و از شما می خواهد هر آنچه را که افراد بد خواستار آن هستند بپردازید. با هوش مصنوعی ، این تماس ها می تواند ایجاد شود حتی اگر خویشاوندی که فکر می کردید فقط شنیده اید برای زندگی او در فیلم ها یا خانه ایمن است.

چگونه می توان خانواده خود را از حمله صوتی عمیق جلوگیری کرد

تصور کنید که مطمئن هستید که تماس گیرنده یکی از بچه های شما یا اقوام دیگری بوده است. شما نمی خواهید در هر زمان به بانک بروید. FBI قبلاً اعلامیه خدمات عمومی (شماره هشدار خدمات I-120324-PSA) را صادر کرده است و به مردم در مورد این حملات هشدار داده است. و G-Men ایده خوبی برای مقابله با چنین حملاتی دارند. دفعه بعد که با یک دوست عزیز صحبت می کنید ، کدی را ایجاد کنید که هیچ کس دیگری آن را نمی شناسد. هر شخص باید کد خاص خود را داشته باشد که فقط آنها می دانند. به این ترتیب ، اگر از دخترتان تماس بگیرید ، می توانید تأیید کنید که آیا این واقعاً صدای او از طریق بلندگوهای آیفون شما یا صدای عمیق ایجاد شده توسط AI است.

این مقاله در ماه دسامبر اظهار نظری از خواننده ای ایجاد کرد که ایجاد کلمه مخفی “احمق ترین و بدبینانه ترین توصیه تا کنون” خوانده است. نویسنده این اظهار نظر نگران است که در زمان استرس ، خویشاوند شما ممکن است کلمه مخفی را به خاطر نکشید و سپس آنچه را که در واقعیت ممکن است یک “تماس باج” واقعی باشد ، نادیده می گیرید. در حالی که این ممکن است یک نگرانی قانونی باشد ، شما باید کد کد را چیزی بیان کنید که حتی در صورت استرس به یاد داشته باشید.

اگر ایده ایجاد یک کلمه کد را دوست ندارید ، گوش دهید تا اطمینان حاصل کنید که صدای بستگان شما روباتیک به نظر نمی رسد و اگر عبارات خاصی از متن تکرار می شوند ، احتمال دارد که به یک صدای عمیق گوش دهید.

ارسال پاسخ