برای آخرین به روزرسانی ها و مطالب اختصاصی در مورد پوشش هوش مصنوعی پیشرو در صنعت ، به خبرنامه های روزانه و هفتگی ما بپیوندید. بیشتر بدانید

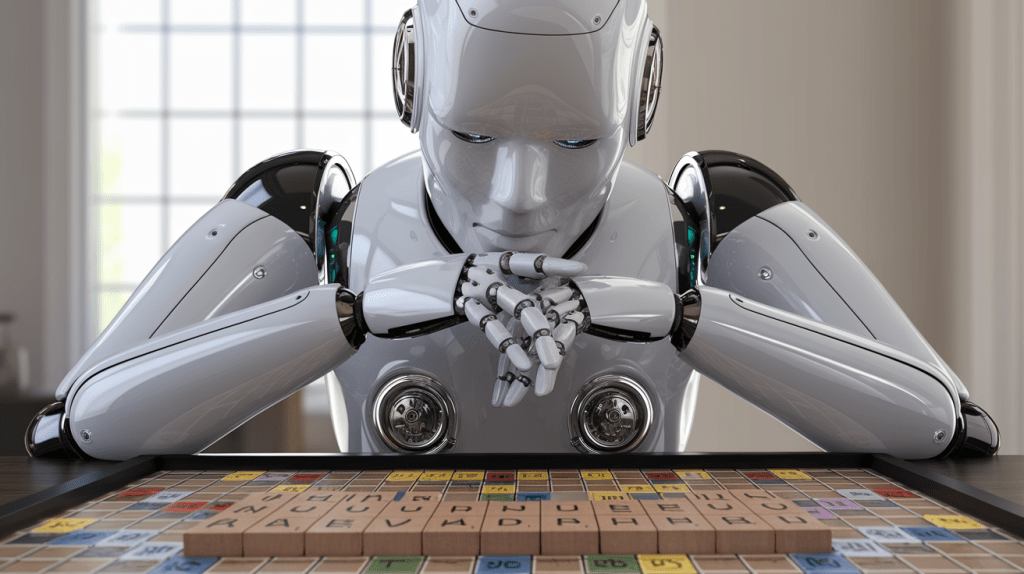

محققان UCLA و META AI D1 را معرفی کرده اند ، یک چارچوب جدید با استفاده از یادگیری تقویت کننده (RL) برای افزایش قابل توجه قابلیت های استدلال مدلهای بزرگ زبان مبتنی بر انتشار (DLLMS). در حالی که بیشتر توجه به مدل های خودگردانی مانند GPT متمرکز شده است ، DLLMS مزایای منحصر به فردی را ارائه می دهد. دادن مهارت های استدلال قوی به آنها می تواند بازده و برنامه های جدید را برای شرکت ها باز کند.

DLLM ها یک رویکرد متمایز برای تولید متن در مقایسه با مدلهای استاندارد خودجوش را نشان می دهند ، و به طور بالقوه مزایایی را از نظر کارآیی و پردازش اطلاعات ارائه می دهند ، که می تواند برای برنامه های مختلف در دنیای واقعی ارزشمند باشد.

درک مدل های زبان انتشار

بیشتر مدل های بزرگ زبان (LLM) مانند GPT-4O و LLAMA Autoregressive (AR) هستند. آنها متن را به صورت متوالی تولید می کنند و نشانه بعدی را فقط بر اساس نشانه هایی که پیش از آن آمده اند ، پیش بینی می کنند.

مدل های زبان انتشار (DLLMS) متفاوت کار می کنند. در ابتدا از مدل های انتشار در مدل های تولید تصویر مانند Dall-E 2 ، Midjourney و انتشار پایدار استفاده شد. ایده اصلی شامل اضافه کردن نویز به یک تصویر تا زمانی که استاتیک خالص باشد ، و سپس آموزش یک مدل برای معکوس دقیق این فرآیند ، از سر و صدا شروع می شود و به تدریج آن را به یک تصویر منسجم می رساند.

تطبیق این مفهوم به طور مستقیم با زبان مشکل بود زیرا متن از واحدهای گسسته (توکن) ساخته شده است ، برخلاف مقادیر مداوم پیکسل در تصاویر. محققان با توسعه مدلهای زبان انتشار ماسک ، این مسئله را غلبه کردند. این مدل ها به جای اضافه کردن سر و صدای مداوم ، با نقاب زدن تصادفی نشانه ها در یک دنباله و آموزش مدل برای پیش بینی نشانه های اصلی کار می کنند.

این منجر به یک فرآیند نسل متفاوت در مقایسه با مدل های خودگردانی می شود. DLLM ها با یک نسخه به شدت ماسک شده از متن ورودی شروع می شوند و به تدریج “unmask” می شوند یا آن را در طی چند مرحله اصلاح می کنند تا خروجی نهایی و منسجم. این نسل “درشت به Fine” DLLM ها را قادر می سازد تا کل زمینه را در هر مرحله در نظر بگیرند ، برخلاف تمرکز فقط روی نشانه بعدی.

این تفاوت مزایای بالقوه DLLMS ، مانند بهبود پردازش موازی در طول تولید را نشان می دهد ، که می تواند منجر به استنباط سریعتر شود ، به خصوص برای توالی های طولانی تر. نمونه هایی از این نوع مدل شامل منبع باز Llada و مدل جیوه منبع بسته از آزمایشگاه های آغازین است.

آدیتا گروور ، استادیار علوم کامپیوتر در UCLA و همکار مقاله D1 ، گفت: “در حالی که LLM های خودکار می توانند از استدلال برای افزایش کیفیت استفاده کنند ، این پیشرفت با هزینه محاسباتی شدید با LLM های استدلال مرزی که 30+ ثانیه در تأخیر برای تولید یک پاسخ واحد ایجاد می شود ، انجام می شود.” “در مقابل ، یکی از مزایای اصلی DLLMS ، راندمان محاسباتی آنها است. به عنوان مثال ، DLLM های مرزی مانند Mercury می توانند از بهترین LLM های خودگردی بهینه شده سریع از آزمایشگاه های مرزی با 10 برابر در توان کاربر استفاده کنند.”

یادگیری تقویت برای DLLMS

علیرغم مزایای آنها ، DLLMS هنوز هم در توانایی های استدلال از مدلهای خودجوش عقب مانده است. یادگیری تقویت برای آموزش مهارتهای استدلال پیچیده LLMS بسیار مهم است. RL با آموزش مدل های مبتنی بر سیگنال های پاداش (اساساً به آنها پاداش می دهد تا مراحل استدلال صحیح یا پاسخ های نهایی) LLM ها را به سمت آموزش بهتر و استدلال سوق داده باشد.

الگوریتم هایی مانند بهینه سازی سیاست پروگزیمال (PPO) و بهینه سازی سیاست نسبی گروه اخیر (GRPO) برای استفاده از RL به طور مؤثر در مدل های خودرسیکی مهم بوده اند. این روشها به طور معمول به محاسبه احتمال (یا احتمال ورود به سیستم) دنباله متن تولید شده تحت خط مشی فعلی مدل برای هدایت فرایند یادگیری متکی هستند.

این محاسبه به دلیل نسل پی در پی ، توکین و تکنیک آنها برای مدل های خودجوش ساده است. با این حال ، برای DLLM ها ، با فرآیند تولید تکراری و غیر توالی خود ، به طور مستقیم محاسبه این احتمال توالی دشوار و از نظر محاسباتی گران است. این یک راه اصلی برای استفاده از تکنیک های RL تعیین شده برای بهبود استدلال DLLM بوده است.

چارچوب D1 این چالش را با یک فرآیند دو مرحله ای پس از آموزش که به طور خاص برای DLLMS نقاب دار طراحی شده است ، مقابله می کند:

- تنظیم دقیق نظارت (SFT): اول ، DLLM از قبل آموزش دیده بر روی مجموعه ای از نمونه های استدلال با کیفیت بالا تنظیم شده است. در این مقاله از مجموعه داده “S1K” استفاده می شود ، که حاوی راه حل های دقیق گام به گام برای مشکلات است ، از جمله نمونه هایی از خود تصحیح و پس از وقوع خطاها. این مرحله با هدف القاء الگوهای استدلال و رفتارهای بنیادی به مدل است.

- یادگیری تقویت با Diffu-GRPO: پس از SFT ، این مدل با استفاده از یک الگوریتم جدید به نام Diffu-GRPO ، آموزش RL را پشت سر می گذارد. این الگوریتم اصول GRPO را با DLLMS تطبیق می دهد. این یک روش کارآمد برای برآورد احتمالات ورود به سیستم ضمن جلوگیری از محاسبات گران قیمت که قبلاً مورد نیاز بود ، معرفی می کند. همچنین شامل یک تکنیک هوشمندانه به نام “ماسک سریع تصادفی” است.

در طول آموزش RL ، بخش هایی از سریع ورودی به طور تصادفی در هر مرحله به روزرسانی پوشانده می شوند. این به عنوان نوعی تنظیم منظم و تقویت داده ها عمل می کند و به مدل امکان می دهد تا از هر دسته از داده ها به طور مؤثرتری بیاموزد.

D1 در برنامه های دنیای واقعی

محققان چارچوب D1 را برای اعلام LLADA-8B ، یک منبع باز DLLM به کار بردند. آنها آن را با استفاده از مجموعه داده استدلال S1K برای مرحله SFT تنظیم کردند. آنها سپس چندین نسخه را با هم مقایسه کردند: مدل پایه Llada ، Llada با تنها SFT ، Llada فقط با Diffu-GRPO و D1-LLADA کامل (SFT و به دنبال آن Diffu-GRPO).

این مدل ها بر روی معیارهای استدلال ریاضی (GSM8K ، MATH500) و کارهای استدلال منطقی (4 × 4 سودوکو ، بازی شماره شمارش معکوس) مورد آزمایش قرار گرفتند.

نتایج نشان داد که D1-LLADA کامل به طور مداوم به بهترین عملکرد در تمام کارها دست یافته است. به طور چشمگیر ، Diffu-GRPO به تنهایی به تنهایی از SFT به تنهایی و مدل پایه استفاده می کند.

گروور گفت: “DLLM های با استدلال مانند D1 می توانند انواع مختلفی از عوامل را برای بارهای کاری سازمانی ایجاد کنند.” “این شامل عوامل برنامه نویسی برای مهندسی نرم افزار فوری و همچنین تحقیقات عمیق بسیار سریع برای استراتژی و مشاوره در زمان واقعی است … با نمایندگان D1 ، گردش کار دیجیتالی روزمره می تواند به طور خودکار خودکار و شتاب شود.”

جالب اینجاست که محققان پیشرفتهای کیفی را مشاهده کردند ، به خصوص هنگام ایجاد پاسخ های طولانی تر. این مدل ها شروع به نمایش “لحظات آه” کردند ، و رفتارهای خود تصحیح و پشتوانه ای را که از نمونه های موجود در مجموعه داده های S1K آموخته شده بودند ، نشان داد. این نشان می دهد که مدل فقط به خاطر سپردن پاسخ ها بلکه یادگیری استراتژی های محکم تر برای حل مسئله نیست.

مدل های خودجوش از نظر فرزندخواندگی از مزیت اول برخوردار هستند. با این حال ، گروور معتقد است که پیشرفت در DLLMS می تواند پویایی زمین بازی را تغییر دهد. برای یک شرکت ، یکی از راه های تصمیم گیری بین این دو این است که آیا برنامه آنها در حال حاضر با تأخیر یا محدودیت هزینه تنگنای است.

به گفته گروور ، DLLM های انتشار با استدلال مانند D1 می توانند در یکی از دو روش مکمل کمک کنند:

- اگر یک شرکت در حال حاضر قادر به مهاجرت به یک مدل استدلال بر اساس یک LLM خودکار نیست ، DLLM های با استدلال با استدلال یک جایگزین پلاگین و بازی ارائه می دهند که به شرکت ها اجازه می دهد تا کیفیت برتر مدل های استدلال را با همان سرعت غیر منطقی ، DLLM خود تجربه کنند.

- اگر برنامه سازمانی بودجه تأخیر و هزینه بیشتری را فراهم کند ، D1 می تواند با استفاده از همان بودجه ، اثری از استدلال طولانی تر ایجاد کند و کیفیت را بهبود بخشد.

گروور گفت: “به عبارت دیگر ، DLLMS به سبک D1 می تواند LLM های اتورگرایی را در محور کیفیت ، سرعت و هزینه تحریک کند.”

ارسال پاسخ