برای آخرین به روزرسانی ها و مطالب اختصاصی در مورد پوشش هوش مصنوعی پیشرو در صنعت ، به خبرنامه های روزانه و هفتگی ما بپیوندید. بیشتر بدانید

حتی در حالی که متا سؤالات و انتقادات مربوط به خانواده جدید Llama 4 Model خود را از بین می برد ، واحد پردازش گرافیک (GPU) Master Nvidia یک مدل زبان بزرگ و کاملاً باز منبع باز (LLM) را بر اساس مدل مدلهای قدیمی Llama-3.1-405B-Medicue منتشر کرده است و این ادعا در نزدیکی عملکرد برتر بر روی انواع مختلفی از Rival Rhival Beschmarks-Outperformmarks-

LLAMA-3.1-NEMOTRON-ULTRA-253B-V1 ، یک پارامتر متراکم 253 میلیارد متراکم است که برای پشتیبانی از استدلال پیشرفته ، دستورالعمل های زیر و گردش کار دستیار هوش مصنوعی طراحی شده است. این نخستین بار در کنفرانس سالانه فناوری GPU NVIDIA (GTC) در ماه مارس ذکر شد.

این نسخه نشان دهنده تمرکز ادامه NVIDIA بر بهینه سازی عملکرد از طریق نوآوری معماری و آموزش هدفمند است.

شب گذشته ، 7 آوریل 2025 اعلام شد ، کد مدل اکنون با وزنه های باز و داده های پس از آموزش در دسترس است. این برنامه برای کارآمد در هر دو حالت “استدلال” و “استدلال خاموش” طراحی شده است ، و به توسعه دهندگان این امکان را می دهد تا بین وظایف استدلال با ترکیب بالا و خروجی های ساده تر بر اساس سوابق سیستم جابجا شوند.

برای استنباط کارآمد طراحی شده است

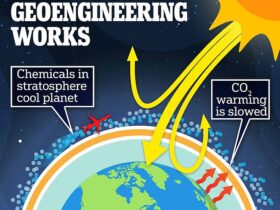

LLAMA-3.1-NEMOTRON-ULTRA-253B کار قبلی Nvidia را در توسعه LLM بهینه سازی شده استنتاج می سازد. معماری آن – که از طریق یک فرآیند جستجوی معماری عصبی (NAS) ساخته شده است – تغییرات ساختاری مانند لایه های توجه پرشده ، شبکه های فدرال ذوب شده (FFN) و نسبت فشرده سازی متغیر FFN را نشان می دهد.

این تعمیرات اساسی معماری ردپای حافظه و تقاضاهای محاسباتی را کاهش می دهد بدون اینکه بر کیفیت خروجی به شدت تأثیر بگذارد و امکان استقرار در یک گره GPU 8 برابر H100 را فراهم می کند.

نتیجه ، طبق گفته NVIDIA ، مدلی است که در حالی که مقرون به صرفه تر برای استقرار در محیط های مرکز داده است ، عملکرد قوی را ارائه می دهد. سازگاری سخت افزار اضافی شامل پشتیبانی از Microarchitectures B100 NVIDIA و Hopper MicroArchitectures است که تنظیمات در هر دو حالت دقیق BF16 و FP8 تأیید شده است.

پس از آموزش برای استدلال و تراز

NVIDIA مدل پایه را از طریق خط لوله چند فاز پس از آموزش تقویت کرد. این شامل تنظیم دقیق نظارت بر حوزه هایی مانند ریاضی ، تولید کد ، گپ و استفاده از ابزار و به دنبال آن یادگیری تقویت با بهینه سازی سیاست نسبی گروه (GRPO) برای تقویت بیشتر عملکرد و عملکرد استدلال است.

این مدل تحت یک مرحله تقطیر دانش بیش از 65 میلیارد نشانه قرار گرفت و به دنبال آن پیشگیری مداوم در 88 میلیارد توکن اضافی انجام شد.

مجموعه داده های آموزش شامل منابعی مانند FineWeb ، Buzz-V1.2 و Dolma بودند. اعلان ها و پاسخ های پس از آموزش از ترکیبی از روش های عمومی و تولید مصنوعی ، از جمله مجموعه داده هایی که به این مدل آموخته اند برای تمایز بین حالت های استدلال آن ترسیم شده است.

عملکرد بهبود یافته در حوزه ها و معیارهای متعدد

نتایج ارزیابی هنگامی که مدل در حالت با استدلال کار می کند ، دستاوردهای قابل توجهی را نشان می دهد. به عنوان مثال ، در معیار MATH500 ، عملکرد از 80.40 ٪ در حالت استاندارد به 97.00 ٪ افزایش یافته است.

به طور مشابه ، نتایج در معیار AIME25 از 16.67 ٪ به 72.50 ٪ افزایش یافت و LiveCodebench بیش از دو برابر می شود و از 29.03 ٪ به 66.31 ٪ می رسد.

سود عملکرد همچنین در کارهای مبتنی بر ابزار مانند BFCL V2 و ترکیب عملکرد ، و همچنین در پاسخ به سؤال کلی (GPQA) مشاهده شد ، جایی که این مدل 76.01 ٪ در حالت استدلال در مقابل 56.60 ٪ بدون آن به دست آورد.

این معیارها با حداکثر طول توالی 32000 توکن انجام شد و هر آزمایش تا 16 بار تکرار شد تا از صحت اطمینان حاصل شود.

در مقایسه با Deepseek R1 ، یک مدل پیشرفته MOE با 671 میلیارد پارامتر کل ، Llama-3.1-Nemotron-Ultra-253B با وجود داشتن کمتر از نیمی از تعداد پارامترها (تنظیمات مدل)-عملکرد خارج از کار در وظایف مانند GPQA (76.01 در مقابل 71.5) ، Ifleeval (83.45) ، Ifforming (83.45). وظایف برنامه نویسی (66.31 در مقابل 65.9).

در همین حال ، Deepseek R1 در ارزیابی های ریاضی خاص ، به ویژه AIME25 (79.8 در مقابل 72.50) از مزیت روشنی برخوردار است و کمی از Math500 (97.3 در مقابل 97.00) استفاده می کند.

این نتایج حاکی از آن است که علی رغم اینکه یک مدل متراکم است ، ارائه NVIDIA مطابقت دارد یا بیش از گزینه های MOE در استدلال و کارهای تراز دستورالعمل عمومی است ، در حالی که کمی در دسته های ریاضی سنگین است.

استفاده و ادغام

این مدل با کتابخانه ترانسفورماتور چهره بغل (نسخه 4.48.3 توصیه شده) سازگار است و از توالی های ورودی و خروجی تا 128،000 توکن پشتیبانی می کند.

توسعه دهندگان می توانند رفتار استدلال را از طریق سوابق سیستم کنترل کرده و استراتژی های رمزگشایی را بر اساس نیازهای کار انتخاب کنند.

برای انجام وظایف استدلال ، NVIDIA توصیه می کند از نمونه گیری دما (0.6) با مقدار بالا P 0.95 استفاده کنید. برای خروجی های قطعی ، رمزگشایی حریص ترجیح داده می شود.

LLAMA-3.1-NEMOTRON-ULTRA-253B از برنامه های چند زبانه پشتیبانی می کند ، با قابلیت های انگلیسی و چندین زبان اضافی از جمله آلمانی ، فرانسوی ، ایتالیایی ، پرتغالی ، هندی ، اسپانیایی و تایلندی.

همچنین برای موارد استفاده مشترک LLM مانند توسعه چت بابات ، گردش کار عامل هوش مصنوعی ، تولید بازیابی-آگوست (RAG) و تولید کد مناسب است.

دارای مجوز برای استفاده تجاری

این مدل تحت مجوز مدل Open NVIDIA Open Open منتشر شد و توسط توافق نامه مجوز جامعه LLAMA 3.1 اداره می شود ، این مدل برای استفاده تجاری آماده است.

Nvidia بر اهمیت توسعه مسئول AI تأکید کرده است ، تیم ها را ترغیب به ارزیابی تراز ، ایمنی و پروفایل های تعصب برای موارد استفاده خاص خود می کند.

Oleksii Kuchaiev ، مدیر مدل AI پس از آموزش در NVIDIA ، این اعلامیه را در X به اشتراک گذاشت و اظهار داشت که این تیم از به اشتراک گذاشتن نسخه آزاد هیجان زده است ، آن را به عنوان یک مدل متراکم 253B طراحی شده با قابلیت های استدلال On/Off و با وزنه های باز و داده ها منتشر کرد.

ارسال پاسخ