برای آخرین به روزرسانی ها و مطالب اختصاصی در مورد پوشش هوش مصنوعی پیشرو در صنعت ، به خبرنامه های روزانه و هفتگی ما بپیوندید. بیشتر بدانید

دو رویکرد محبوب برای سفارشی کردن مدل های بزرگ زبان (LLM) برای کارهای پایین دست تنظیم دقیق و یادگیری درون متن (ICL) است. در یک مطالعه جدید ، محققان در Google Deepmind و دانشگاه استنفورد قابلیت های تعمیم این دو روش را مورد بررسی قرار دادند. آنها دریافتند که ICL توانایی تعمیم بیشتری دارد (هرچند که در هنگام استنتاج با هزینه محاسبات بالاتر همراه است). آنها همچنین یک رویکرد جدید را برای به دست آوردن بهترین های هر دو جهان پیشنهاد می کنند.

این یافته ها می تواند به توسعه دهندگان کمک کند تا هنگام ساختن برنامه های LLM برای داده های سازمانی خود ، تصمیمات اساسی بگیرند.

آزمایش نحوه یادگیری مدل های زبان ترفندهای جدید

تنظیم دقیق شامل گرفتن LLM از قبل آموزش دیده و آموزش بیشتر آن در یک مجموعه داده کوچکتر و تخصصی است. این پارامترهای داخلی مدل را برای آموزش دانش یا مهارت های جدید تنظیم می کند. از طرف دیگر ، یادگیری درون متن (ICL) پارامترهای اساسی مدل را تغییر نمی دهد. در عوض ، LLM را با ارائه نمونه هایی از کار مورد نظر به طور مستقیم در سریع ورودی راهنمایی می کند. سپس این مدل از این مثالها برای فهمیدن نحوه رسیدگی به یک پرس و جو مشابه جدید استفاده می کند.

محققان با استفاده از این دو روش به طور دقیق مقایسه می کنند که چگونه مدل های خوب به کارهای جدید تعمیم می دهند. آنها “مجموعه داده های مصنوعی کنترل شده از دانش واقعی” را با ساختارهای پیچیده و خود سازگار مانند درختان خانوادگی خیالی یا سلسله مراتب مفاهیم داستانی ساختند.

برای اطمینان از اینکه آنها توانایی مدل برای یادگیری اطلاعات جدید را آزمایش می کنند ، آنها تمام اسم ها ، صفت ها و افعال را با اصطلاحات مزخرف جایگزین کردند و از هرگونه همپوشانی با داده هایی که LLM ها در طول پیش از آموزش با آنها روبرو شده اند ، جلوگیری می کنند.

سپس مدل ها بر روی چالش های مختلف عمومی سازی مورد آزمایش قرار گرفتند. به عنوان مثال ، یک آزمون درگیر شد معکوس های سادهبشر اگر مدلی آموزش داده می شد که “FEMP از GLON خطرناک تر است” ، آیا می توان به درستی استنباط کرد که “گلون از FEMP کمتر خطرناک است”؟ یک آزمایش دیگر روی آن متمرکز شده است هجوم ساده، نوعی کسر منطقی. اگر به “همه گلون YOMP” و “همه Troff Glon هستند” می گویند ، آیا این مدل می تواند نتیجه بگیرد که “همه Troff Yomp هستند”؟ آنها همچنین از “معیار ساختار معنایی” پیچیده تر با سلسله مراتب غنی تر از این حقایق ساخته شده برای آزمایش درک ظریف تر استفاده کردند.

“اندرو لمپینن ، دانشمند تحقیقاتی در Google Deepmind و نویسنده اصلی مقاله ، گفت:” نتایج ما در درجه اول در تنظیمات در مورد چگونگی تعمیم مدل ها به کسر و معکوس از تنظیم دقیق بر روی ساختارهای دانش جدید متمرکز شده است ، با پیامدهای واضح برای موقعیت هایی که از تنظیم دقیق برای تطبیق یک مدل با اطلاعات خاص و اختصاصی استفاده می شود. “

برای ارزیابی عملکرد ، محققان فلش Gemini 1.5 را در این مجموعه داده ها تنظیم کردند. برای ICL ، آنها قبل از مطرح کردن سؤالات آزمون ، کل مجموعه داده های آموزشی (یا زیر مجموعه های بزرگ) را به عنوان زمینه ای برای یک مدل تنظیم شده توسط دستورالعمل تغذیه کردند.

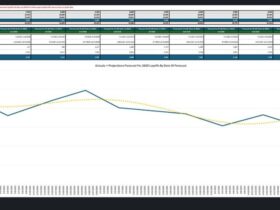

نتایج به طور مداوم نشان می دهد که ، در تنظیمات همسان ، ICL منجر به تعمیم بهتر از تنظیم دقیق استاندارد می شود. مدل های با استفاده از ICL به طور کلی در کارهایی مانند معکوس کردن روابط یا کسر منطقی از متن ارائه شده بهتر بودند. مدل های از قبل آموزش دیده ، بدون تنظیم دقیق یا ICL ، عملکرد ضعیفی دارند و نشانگر جدید بودن داده های آزمون است.

لمپینن گفت: “یکی از اصلی ترین معاملات مورد توجه این است که ، در حالی که ICL به تنظیم دقیق نیاز ندارد (که باعث صرفه جویی در هزینه های آموزش می شود) ، به طور کلی با هر استفاده از نظر محاسباتی گران تر است ، زیرا نیاز به ارائه زمینه اضافی برای مدل دارد.” “از طرف دیگر ، ICL تمایل دارد که برای مجموعه داده ها و مدلهایی که ما ارزیابی کرده ایم ، بهتر تعمیم دهد.”

یک رویکرد ترکیبی: تقویت تنظیم دقیق

محققان با توجه به مشاهده اینكه ICL در تعمیم انعطاف پذیر برتری دارد ، روش جدیدی را برای تقویت تنظیم دقیق پیشنهاد كردند: اضافه كردن استنتاج های درون متن به داده های تنظیم دقیق. ایده اصلی این است که از قابلیت های ICL خود LLM برای تولید نمونه های متنوع تر و غنی تر استنباط شده استفاده کنید و سپس این نمونه های افزوده را به مجموعه داده های مورد استفاده برای تنظیم دقیق اضافه کنید.

آنها دو استراتژی اصلی افزایش داده را مورد بررسی قرار دادند:

- بوها استراتژی محلی: این رویکرد بر روی بخشهای جداگانه اطلاعات متمرکز است. از LLM خواسته می شود تا جملات منفرد را از داده های آموزش بازگرداند یا استنتاج مستقیم از آنها ، مانند تولید معکوس.

- بوها استراتژی جهانی: به LLM داده های کامل آموزش به عنوان زمینه داده می شود ، سپس با پیوند دادن یک سند یا واقعیت خاص با بقیه اطلاعات ارائه شده ، استنباط می شود و منجر به اثری از استدلال طولانی تر از استنتاج های مربوط می شود.

هنگامی که مدل ها در این مجموعه داده های افزوده تنظیم شدند ، دستاوردها معنی دار بودند. این تنظیم دقیق تقویت شده به طور قابل توجهی تعمیم یافته است ، از نه تنها تنظیم دقیق استاندارد بلکه ICL ساده نیز بهتر است.

لمپینن گفت: “به عنوان مثال ، اگر یکی از اسناد شرکت می گوید” XYZ ابزاری داخلی برای تجزیه و تحلیل داده ها است ، “نتایج ما نشان می دهد که ICL و افزایش یافته افزایش یافته در فعال کردن مدل برای پاسخ به سؤالات مرتبط مانند” چه ابزارهای داخلی برای تجزیه و تحلیل داده ها وجود دارند؟ “

این رویکرد یک مسیر قانع کننده به جلو برای شرکت ها ارائه می دهد. با سرمایه گذاری در ایجاد این مجموعه داده های ICL-Auged ، توسعه دهندگان می توانند مدل های تنظیم شده خوبی بسازند که قابلیت های تعمیم قوی تری را نشان می دهند.

این می تواند به برنامه های LLM قوی تر و قابل اعتماد تر منجر شود که بر روی ورودی های متنوع و در دنیای واقعی بهتر عمل می کنند بدون اینکه هزینه های مداوم زمان استنباط مرتبط با سوابق بزرگ درون متن را تحمل کنند.

لمپینن گفت: “تنظیم دقیق افزودنی به طور کلی باعث می شود فرآیند تنظیم دقیق مدل گرانتر شود ، زیرا به یک مرحله اضافی از ICL برای تقویت داده ها نیاز دارد و به دنبال آن تنظیم دقیق می شود.” “این که آیا این هزینه اضافی با تعمیم بهبود یافته ، به مورد استفاده خاص بستگی دارد. با این وجود ، از نظر محاسباتی ارزان تر از استفاده از ICL هر بار که مدل استفاده می شود ، در صورت استهلاک در بسیاری از استفاده های مدل.”

در حالی که لمپینن خاطرنشان کرد: تحقیقات بیشتری لازم است تا ببینیم که چگونه مؤلفه هایی که آنها در تنظیمات مختلف مورد مطالعه قرار می گیرند ، وی افزود که یافته های آنها نشان می دهد که توسعه دهندگان ممکن است بخواهند در مواردی که عملکرد ناکافی را به تنهایی انجام می دهند ، به کاوش در تنظیم دقیق بپردازند.

لمپینن گفت: “در نهایت ، ما امیدواریم که این کار به علم درک یادگیری و تعمیم در مدل های بنیاد و عملی بودن تطبیق آنها با کارهای پایین دست کمک کند.”

ارسال پاسخ